Mamba为什么胜利

Mamba为什么胜利

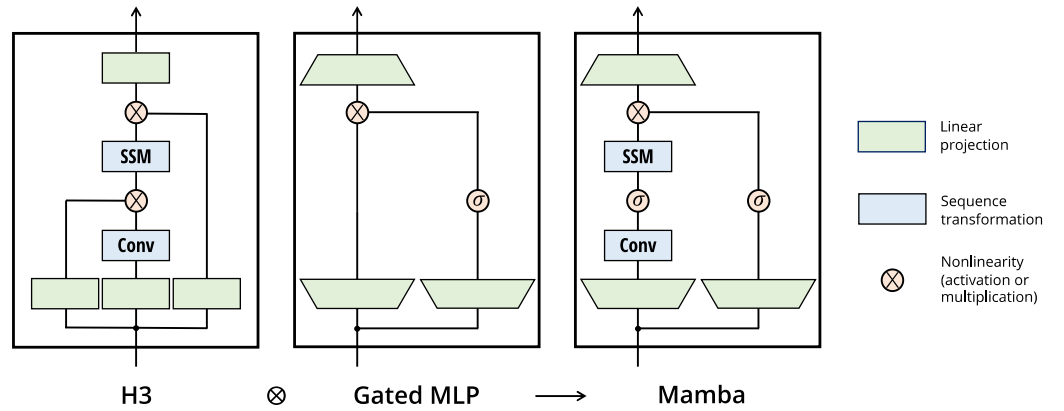

Mamba模型一出现就引起的广泛的讨论,尽管一开始论文没有被接收,很多人已经惊呼:“Transformer已死!Mamba即将取代Transformer成为新神!”,今年的6月4日,原作者推出了Mamba2,这次成功被ICML接收。抛开梗化的名称不论,从其论文展示出的性能上看确实击败了transformer。

众所周知,当今的transformer面临的问题是attention计算量与token的数目存在平方的关系,如果序列过长的话,transformer网络将给计算系统的IO, 内存与计算单元全部上强度。动辄100天的训练时长让很多小作坊望而却步。而Mamba正是为了解决这个问题而提出的,它的类RNN的计算模式在长序列下更加的硬件友好。

我们可以把mamba视为硬件和软件协同进化的产物。在2017年以前的RNN时代,我们拥有很强的硬件,但缺少能够利用好硬件平台的强大算法。RNN 递归的计算方式让其无法做好很好的并行化处理。于是transformer横空出世,以其强大的并行性迅速用满了所有的计算资源。它不仅取得了巨大的成功,甚至刺激硬件层面做出新的迭代。而现在的局面是硬件跟不上软件,所以Mamba重新回到了递归的计算方式,可以说是软件对硬件的一种妥协。其内存层次结构(memory hierarchy)感知的创新更是算法向硬件的一次奔赴,所以Mamba在这轮的博弈中胜出。不过可以预见在将来,硬件计算平台进一步迭代后,并行化的优势将进一步被强调,新的架构也将诞生。目前已经发现了Mamba存在训练速度慢的问题,我们可能会迎来Mamba out的时刻。

本博客所有文章除特别声明外,均采用 CC BY-NC-SA 4.0 许可协议。转载请注明来自 _ConchNest🐚!