Ayaka——对attention sparsity进行低秩估计

Ayaka——对attention-sparsity进行低方根估计

文章名称为:

Ayaka: A Versatile Transformer Accelerator With Low-Rank Estimation and Heterogeneous Dataflow

这是清华大学团队与2024年发表在JSSC上的文章。包含以下两个feature:

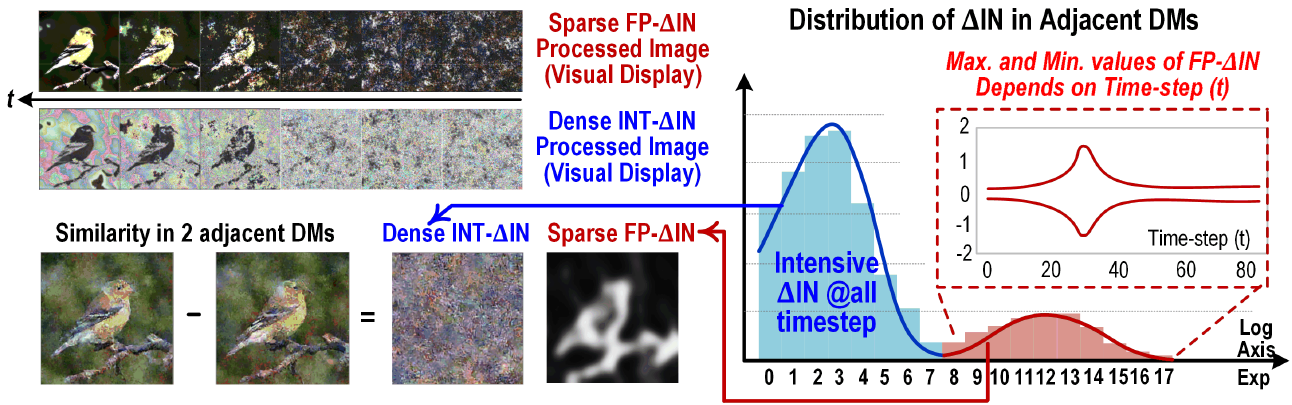

低秩估计:通过低秩近似技术,在保证模型精度的同时,减少Transformer模型的参数数量和计算复杂度。

异构数据流:设计了一种灵活的异构数据流架构,能够高效地处理Transformer模型中的不同计算任务,提高硬件资源的利用率。

提到了对FFN的优化

测试的数据集采用了long-range arena,它包含从1K-16K token length的各个任务用来测试efficient Transformer算法在长文本下的性能。

本博客所有文章除特别声明外,均采用 CC BY-NC-SA 4.0 许可协议。转载请注明来自 _ConchNest🐚!