你只需要加法——用整数加法运算逼近浮点数乘法

你只需要加法——用整数加法运算逼近浮点数乘法

本文由加州的BitEnergy AI公司提出

文章名为:

Addition is All You Need for Energy-Efficient Language Models

首先抛出一个论点:

用Int32加法操作来预测Fp32浮点数操作仅仅消耗原来的2.7%的功耗。

作者的实验很有说服力,把transformer-based LLMs中的乘法操作全部替换为L-Mul,几乎不产生精度损失。

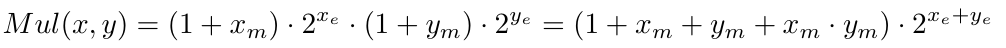

其将标准的浮点数乘法:

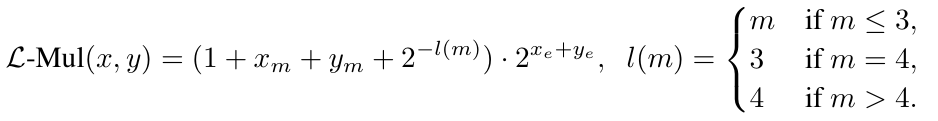

替换为:

实际部署时,需要额外用于加l(m)的加法器,和处理偏置f1和f2的加法器。

问:该方法和adderNet有什么区别

本博客所有文章除特别声明外,均采用 CC BY-NC-SA 4.0 许可协议。转载请注明来自 _ConchNest🐚!